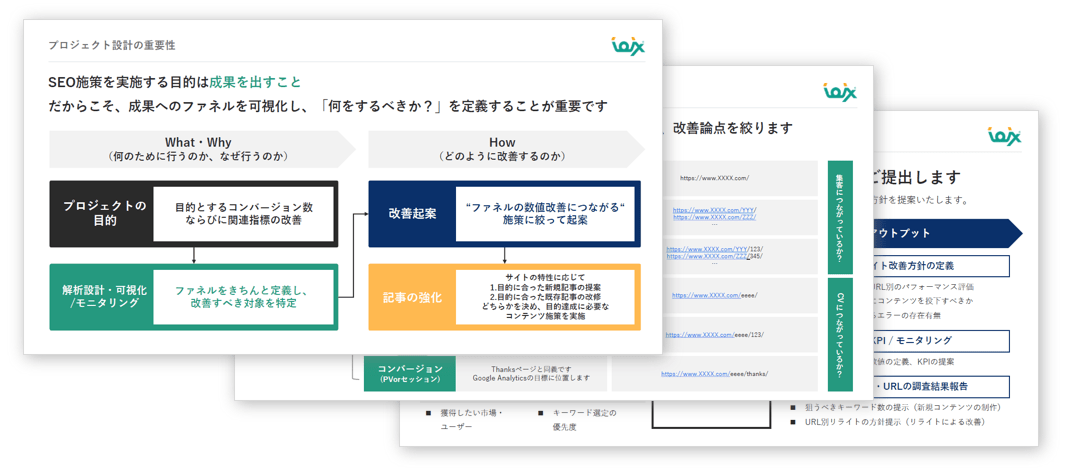

SEOコンサルティングサービスのご案内

専門のコンサルタントが貴社サイトのご要望・課題整理から施策の立案を行い、検索エンジンからの流入数向上を支援いたします。

無料ダウンロードする >>

無料ダウンロードする >>

先日開催されたSMX ウエストでは、多くの良質な情報が提供された。以下に私が最も秘密にしたい、役立つ情報の一部を挙げていく。

先日開催されたSMX ウエストでは、多くの良質な情報が提供された。以下に私が最も秘密にしたい、役立つ情報の一部を挙げていく。

グーグルのマット・カッツ氏は、変更が完璧ではない点を認めつつ、検索者のフィードバックは前向きなものが圧倒的に多かったと述べた。カッツ氏は、変更は手動による例外は皆無であり全てアルゴリズムに基づいていると伝えた。

マット・カッツ氏は、サイト上の質の低いコンテンツがサイト全体のランキングを落とす可能性について繰り返し説明していた。ページの質を改善する行為は、あるいは、ページを完全に削除する行為は、通常、この問題を解決する手段として良いとされているが、場合によっては異なる対策が必要とされる可能性もある。

例えば、ビジネスのレビューサイトは、ビジターがレビューを残すことが出来るように、各店舗に対するリスティングを含めたいと望むだろう。しかし、この類のページには、通常、ビジターがレビュー情報を投稿するまでは、ウェブ全体で重複する店舗を説明する情報しか掲載されていない。Q & Aサイトの場合、ビジターが回答を提供するまでは回答のない質問を掲載することになる。

このような場合、グーグルのマイリー・オイェ氏は、固有で質の高いコンテンツを用意するまでは<meta name=robots content=noindex>をページに用いることを勧めていた。オイェ氏は、この手法をrobots.txtを介してブロックする手法よりも推奨している。検索エンジンがページの存在を把握し、履歴を構築して、ページのブロックが解除されると、すぐに適切に格付けされるようにするためだ。パネルで私はこの件を取り上げ、大規模なサイトは例外であり、robots.txtは、検索エンジンのボットが質の高いコンテンツを持つページ上でクロールに確実に時間を費やしてもらう効果があると伝えた。

カッツ氏は、サイトに広告を掲載していることが、本質的に質を下げるものではないと述べた。しかし、度を超えている場合はその可能性がある。過去に投稿したエントリの中で、この変更、特に折り返し部分までは広告しか見当たらないージや広告が異常に多いページにおいては、広告ではないコンテンツを探すのが大変な状況は、劣悪なユーザーエクスペリエンスを与えることになると綴った。

マット・カッツ氏は、また、グーグルが、サイトがユーザーにとって有益ではないと判断する場合、クロールの頻度が少なくなると述べた。この点に関しては、個人的には、サーバーログを確認して、グーグルボットがクロールしているページを特定し、さらに、その頻度をチェックしてみることを勧める。そうすることで、サイトに対する質の変化の影響が及ぶまでに、どれぐらい時間がかかるのかを大体把握することが出来るだろう。例えば、グーグルが30日に1度しかクロールしていないなら、質を改善してもランキングが10日間で変わることはないだろう。

カッツ氏は、現時点でアルゴリズムの変更が行われたのは米国のみだが、国外でもテストが行われており、“数週間以内”に他国にも展開されると認めた。また、同氏は、この変更がターゲットにした質の低いコンテンツのタイプは、他の国々よりも米国で行き渡っているため、米国以外では影響はそれほど大きくはないとも述べた。

マット・カッツ氏は、今年さらに多くの変更が行われる予定があると述べた。カッツ氏は、今年は質の低いコンテンツおよびコンテンツファームを検索結果で目立たないようにすること、そして、コンテンツの元々のクリエイターがより多くのスポットライトを浴びるようにすることに焦点を当てていると明言している。グーグルは、例えば、オリジナルのコンテンツが上位に格付けされるように取り組んでおり、また、シンジケート版のソースがページに対する価値のシグナルに基づいて最も高いランクを得ている際に、オリジナルのソースのランクとシンジケート版のソースのランクを交換する試みを行う可能性があるようだ。また、グーグルは、スクレイプ(収集)されたコンテンツを特定する取り組みも継続している。

つまりSEOは継続的に変化しなければならないと言う意味だろうか?検索エンジンのシグナルに対してではなく、ユーザーに対して価値を高めることを信条としているなら答えは「No」だ。カッツ氏も言っていたように、「5年前に伝えたことは今でも妥当である: アルゴリズムを追いかけるのではなく、ユーザーが好むサイトを作る努力をしよう」。

ギル・ライク氏は、このアドバイスに対する一部の人々の解釈に関して私が感じたフラストレーションを綴っていた。

「SEOに訊けセッション」は、かつてはブラックハットとホワイトハットが対決する構図であった。今回、参加者の顔ぶれは同じだが、“ユーザーに焦点派”と“ユーザーに焦点を絞っているサイトが持つ足跡を作る派”に構図が変わっていた。バネッサ・フォックス氏は、他のパネリストが単純にブラックハットだった時代よりもこの議論が遥かに面倒になっている点に気づいていた。

その通りだ。例えば、パネルディスカッションで、ブルース・クレイ氏は、ランクが落ちたサイト、および落ちなかったサイトを分析し、ランクが落ちたサイトは全ての記事のワード数がほとんど同じであった傾向が見られたと述べた。つまり、記事の長さが同一にならないことが重要だと言ったのだ。私はオーディエンスに対して、このセッションの収穫として、サイトをチェックして、それぞれのページのコンテンツの長さが異なる点を裏付けるのではなく、それぞれのコンテンツが有益かどうかを確認してもらいたいと伝えた。

サイトが“ユーザーに焦点を絞る足跡を持っている”点を確実にするためには、ユーザーに焦点を絞ることが最善の方法である。

「ホワイトハット」のクローキングに関する情報が数多く舞い込んできている。ホワイトハットのクローキングとは、サイトがスパム目的ではない理由でビジターに見せるコンテンツとは異なるコンテンツを検索エンジンに見せるように設定されているケースを意味するようだ。例えば、ビジターにはフラッシュが表示されているものの、検索エンジンにはHTMLのコンテンツが表示されている場合や、サイトが検索エンジンには広告を見せない場合、もしくはURLのカノニカルなバージョンしか表示していない場合などである。

一部のSEO業者は、グーグルがこの類のクローキングを大目に見てくれると言っている。しかし、マット・カッツ氏は、この主張を否定し、次のように述べた:

「ホワイトハットのクローキングはグーグルの利用規約を侵害している。グーグルは、「ホワイトハット」のクローキングを例外的に扱わなければいけない理由はない。そのようなことを言われて真に受けているようでは危険極まりない。」

マット・カッツ氏は、グーグルボットに対する特別なコードが、ユーザーエージェントまたはIPアドレスによってサイトに含まれている場合、グーグルは、クローキングと理解し、サイトに対して対策を講じる可能性があると述べた。

ダニー・サリバン氏は、「first-click free」プログラム(註:Googleが提唱する、会員制のサイトの内部ページのコンテンツをGooglebotにだけ見せてインデックスさせる場合、ユーザーが検索結果ページからアクセスしてきた時にはログインページに誘導する前にその1ページだけはGooglebotに見せたものと同じ正規コンテンツを見せるべき、というGoogleがクローキングと見なさない会員制サイト向けのSEO対策)はホワイトハットのクローキングだと断定したが、カッツ氏は、グーグルボットとグーグル検索を経由したビジターに同じ内容の情報を見せていたと述べ、サリバン氏の見解に異を唱えた。また、カッツ氏は、コンテンツをジオロケーションを基に表示する行為はクローキングには当たらないと述べた。グーグルボットのIPに対する特別なケースではないためだ(地理的なロケーションに関連している)。

複数のサーチエンジンランドのエントリ(このエントリとこのエントリを含む)は、検索エンジンフレンドリーなURLを見せる行為は、検索エンジンから問題視されていないと断言しているが、検索エンジン、特にグーグルは、この行為は推奨されるようなものではないと明言している。

このようなクローキングが問題ないと考える人達は、2005年のSES シカゴでのグーグルの代表者が述べた見解を当てにしている。しかし、2008年には、マット・カッツ氏が、「ユーザーエージェントを基にURLを書き直すクローキングは、少なくともグーグルにとっては許容出来るものではない」と私に明言していた(2005年のイベントはグーグルの代表者にとって初めての講演であり、クローキングの複雑さをよく理解していなかったのではないかと個人的には考えている)。

いずれにせよ、URLの問題を回避する策は豊富にある。URLを直接修正することが出来なくても、またはリダイレクトを実装することが出来なくても、rel=canonicalリンク属性、または、グーグルウェブマスターツールズのパラメータの処理機能を使えばよい(ビングウェブマスターツールズも同様の機能を用意している)。

-999pxのCSSテキストのインデントをイメージの代わりに使う行為は許容されるのだろうか?オイェ氏は、以前、個人のブログでこのような方法でテキストを隠す行為は、例えスパム目的ではなく、アクセシビリティを確保する目的であっても、グーグルのウェブマスターガイドラインを違反していると受け取られる可能性があると述べていた。通常、異なる方法を用いることが出来るはずだ(ALT属性やCSSスプライト等)。また、SMXのステージで、オイェ氏は、font-faceを利用することを勧めていた。これは実装するのは難しいが、フォントファイル自体に関しては、自分で構築するのではなく、グーグル ウェブ・フォントを利用する手もある。

カッツ氏は、その後に行われたセッションでこの手法に賛成していた: 「テキストを隠すのは、あまり良い取り組みとは言えない。オイェ氏が先程のセッションで取り上げていたと思う。」

新しいユーザーと戻ってきたユーザーに異なるコンテンツを表示する件を誰かが尋ねていた。マット・カッツ氏もビングのデュアン・フォレスター氏もこの類の手法には注意するよう呼びかけていた。通常、この種のシナリオは、クッキーを介して実行されることが多い。新しいユーザーもグーグルもサイトへのクッキーを持っていないが、戻ってきたユーザーはクッキーを持つことになる。カッツ氏は、グーグルボットを新しいユーザーと同じように対処したいなら、これで通常は問題はないと述べた。

リンクは今後も重要だが、検索エンジンが認めたメソッドを使って、どのようにリンクを集めることが出来るのだろうか?マット・カッツ氏は「自分に問いかけるべきだ」と述べていた。「人々に好かれるサイトを作るにはどうすればいいのか?」ブランドの価値をもたらす、印象的なサイトを忠実なオーディエンスと共に構築すれば(必ずしも検索を通してではなく)、リンクが集まってくるだろう。

「どうすればeコマースサイトの内部のページに対するリンクを集めることが出来るのか?」と言う質問が投げかけられていた。製品ページ自体は面白いわけでもなく、編集コンテンツを多数抱えているわけではない。カッツ氏は、データを分割する異なる手段を特定して、その分野のオーソリティになることを勧めていた。

あまりない。フォレスター氏もカッツ氏もウェブ全体で記事を何度もシンジケートしても有益なリンクを提供するわけではなく、また、編集を通じて与えられるわけでもないと述べた。フォレスター氏は単刀直入に次のように語っていた。「アーティクルマーケティングはやめておこう。」

カッツ氏は、同じ分野のオーソリティサイトに連絡を取り、同サイトのために作成した記事を投稿してもらえるかどうか尋ねてみる取り組みを推奨していた。オーソリティサイトがそのコンテンツを投稿するに値すると判断したら、誰でも何でも配信可能な記事のハブから投稿したケースとは全く異なる結果になるはずだ。

有料リンクが検索エンジンのガイドラインの違反に該当する一方、プレスリリースのサービスに料金を払ってグーグルニュース等に記事を配信してもらうことは出来るが、このようなリンクはカウントされるのかを尋ねた人がいた。マット・カッツ氏は、プレスリリース内のリンク自体はページランクに対してカウントされることはないが、プレスリリースを読んだジャーナリストがその情報を記事で取り上げたら、そのニュース記事内のリンクはすべてカウントされると明言した。

リツイートだけでもランキングを上げる効果があると結論付けていた、先日のSEOmozのエントリについて質問をしていた人がいた。カッツ氏は、グーグルのコアランキングチームを統率するアミット・シングハル氏に尋ねてみたところ、ツイート内のリンクはグーグルのランキングの一環ではないため、SEOmozのエントリの結論は正しくないと述べた。それよりも、ツイートを後ほど見た人がリンクを張った場合など、その他の間接的なファクターの方が効果的であった(このようなツイートはその他のサイトにエンベッドされ、その後リンクとして扱われるのではないかと個人的には考えている)

マット・カッツ氏は、リツイートなどのシグナルはリアルタイムの検索結果では役に立つ可能性があると述べ、検索者にツイートされたページが表示されるようになった先日の変更について語った。

一部の人達は、グーグルのアルゴリズムがツイートされなかったサイトよりも、ツイートされたサイトのランキングを上げると勘違いしていた。しかし、カッツ氏は、検索結果を検索者のソーシャルネットワークのコネクショをベースにパーソナライズする変更について数週間前に話していた。マット・マギー氏はサーチエンジンランドの記事で次のように説明していた:

場合によっては、グーグルはソーシャル検索の指標を使って結果に注釈を付けることがあるだろうとグーグルのプロダクトマネージメント・ディレクターを務めるマイク・キャシディ氏が述べている。グーグルの従来のランキングアルゴリズムは、リスティングが表示される場所を特定するものの、ソーシャルの要素を反映して、リスティングが強化される可能性がある。

また場合によっては、ソーシャル検索の要素は、ページのランキングを変えるだろう – つまり“通常”よりもページを高く格付けする可能性があるのだ。これは、個人の関係に基づくパーソナライズ機能であると付け加えておこう。ランキングのインパクトは、コネクションの強度により異なり、人によって異なる結果が表示されるだろう。

これは一昔前から問われていたことだが、先日、複数の著名なサイトが、外部リンクのプロフィールにおいて検索エンジンのガイドラインを違反したために、ランクを降格されたこともあって気になっている人がいたようだ。カッツ氏は、繰り返し、別のサイトに害を与えることは出来ないと説明していた。アルゴリズムは、検索エンジンのガイドラインを違反しているリンクをカウントしないように設定されている。降格は、通常、大規模な違反が見つかった場合のみに行われる。

数名が、全く同じドメインを持ち、全く同じアンカーテキストを持つ大量の被リンクを抱えるスパムサイトがグーグルおよびビングで上位にランクインしている点を指摘していた。マット・カッツ氏はこの点については調査中だと述べるにとどまった。

カッツ氏はこの仕組みの基本について繰り返し説明した:

この記事は、Search Engine Landに掲載された「Lessons Learned at SMX West: Google’s Farmer/Panda Update, White Hat Cloaking, And Link Building」を翻訳した内容です。

色々盛り沢山の内容でした!ここまでまとめてもらうと、イベント行く必要性あったのかな、と若干思ったりもしますが。。。汗 ま、雰囲気を感じることも重要ですからね。しかし今回は何といってもパンダアップデートが直近であったこともあり、関連する話題で盛り上がりましたね。後は上記にも少し書かれていますがツイッターなどのソーシャルメディア系も今後のSEO/SEMには欠かせない存在となりそうです。イベント終了後に日本では地震、その後の震災が今も続いていたりと大変な日々が続いていますが、日本だけ遅れを取るわけにもいきませんし、負けずに情報収集&我々も進化していきたいと思います! — SEO Japan

SEO最新情報やセミナー開催のお知らせなど、お役立ち情報を無料でお届けします。